2계층 통신 vs 3계층 통신

Today Keys : l2, l3, 2계층, 3계층, local, remote , IP주소, MAC주소, ARP, 프로토콜, address, resolution, protocol 본 포스팅은 'IT 엔지니어를 위한 네트워크 입문' [길벗] 서적에 포함된 '3. 네트워크 통신하기'의 내용 3.5.1장의 내용입니다. 2계층 통신 vs 3계층 통신 2계층 통신, 3계층 통신(또는 레이어 2 통신, 레이어 3 통신)은 원래 정확한 표현은 아니지만 실무에서 많이 쓰는 표현입니다. 정확한 표현은 로컬 네트워크 통신, 원격지 네트워크 통신입니다. 단말 간의 통신은 애플리케이션 계층부터 시작해 캡슐화, 디캡슐화를 거쳐 통신하는데 로컬 네트워크에서 직접 통신할 경우(출발지와 목적지가 같은 네트워크에 존재할 경우), 라..

2계층 통신 vs 3계층 통신

Today Keys : l2, l3, 2계층, 3계층, local, remote , IP주소, MAC주소, ARP, 프로토콜, address, resolution, protocol 본 포스팅은 'IT 엔지니어를 위한 네트워크 입문' [길벗] 서적에 포함된 '3. 네트워크 통신하기'의 내용 3.5.1장의 내용입니다. 2계층 통신 vs 3계층 통신 2계층 통신, 3계층 통신(또는 레이어 2 통신, 레이어 3 통신)은 원래 정확한 표현은 아니지만 실무에서 많이 쓰는 표현입니다. 정확한 표현은 로컬 네트워크 통신, 원격지 네트워크 통신입니다. 단말 간의 통신은 애플리케이션 계층부터 시작해 캡슐화, 디캡슐화를 거쳐 통신하는데 로컬 네트워크에서 직접 통신할 경우(출발지와 목적지가 같은 네트워크에 존재할 경우), 라..

Azure VNet -Peering 5 (Gateway Transit 설정)

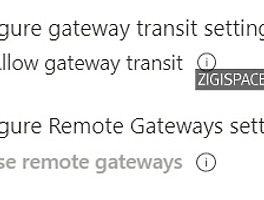

Today Keys : peering, gateway , transit , allow, remote, 피어링, 게이트웨이, azure, cloud, 네트워크 이번 포스팅에서는 VNet Peering을 통해서 설정 시에, Peering을 맺은 상대편 VNet의 Gateway를 통해서 상대편 VNet과 연결된 외부와 통신을 할 수 있는 Gateway Transit에 설정에 대해서 다룹니다. 관련 속성에 대해서는 기존 포스팅(https://zigispace.net/1089) 을 참고하시면 됩니다 Gateway Transit 설정 테스트를 위한 환경입니다. 먼저 Gateway Transit과 관련된 Peering 설정만 다루기 때문에 아래 테스트 환경을 먼저 설명하면, ZIGI-VNet0과 ZIGI-VNet1 ..

Azure VNet -Peering 5 (Gateway Transit 설정)

Today Keys : peering, gateway , transit , allow, remote, 피어링, 게이트웨이, azure, cloud, 네트워크 이번 포스팅에서는 VNet Peering을 통해서 설정 시에, Peering을 맺은 상대편 VNet의 Gateway를 통해서 상대편 VNet과 연결된 외부와 통신을 할 수 있는 Gateway Transit에 설정에 대해서 다룹니다. 관련 속성에 대해서는 기존 포스팅(https://zigispace.net/1089) 을 참고하시면 됩니다 Gateway Transit 설정 테스트를 위한 환경입니다. 먼저 Gateway Transit과 관련된 Peering 설정만 다루기 때문에 아래 테스트 환경을 먼저 설명하면, ZIGI-VNet0과 ZIGI-VNet1 ..

Azure VNet - Peering 4 (Peering 속성)

Today Keys : peering, azure, transit setting, gateway, remote, 원격, 게이트웨이, 피어링, cloud, 클라우드 Azure VNet Peering에서 사용되는 3가지 옵션에 대해서 알아봅니다. Virtual network access setting / Gateway transit setting / Remote Gateway Setting Virtual network access settings ▪ 기본 활성화이며, VNet Peering을 통해서 통신이 허용되도록 함 ▪ 비 활성화 시에, Peering이 맺어져 있어도 통신을 차단 함. - Peering을 유지한 채로 VNet 간의 통신 제어 가능. ▪ Peering 맺은 VNet 간의 모두 활성화를 해야..

Azure VNet - Peering 4 (Peering 속성)

Today Keys : peering, azure, transit setting, gateway, remote, 원격, 게이트웨이, 피어링, cloud, 클라우드 Azure VNet Peering에서 사용되는 3가지 옵션에 대해서 알아봅니다. Virtual network access setting / Gateway transit setting / Remote Gateway Setting Virtual network access settings ▪ 기본 활성화이며, VNet Peering을 통해서 통신이 허용되도록 함 ▪ 비 활성화 시에, Peering이 맺어져 있어도 통신을 차단 함. - Peering을 유지한 채로 VNet 간의 통신 제어 가능. ▪ Peering 맺은 VNet 간의 모두 활성화를 해야..

Docker : Part 6

Docker,Remote, API,client, library, python,host, 원격, 리모트, 도커, git : today Key Docker의 6번째 포스팅입니다. 이번 포스팅에서는 Docker를 Remote에서 제어할 수 있도록 제공되는 Remote API client libraries에 대해서 다뤄봅니다. 보안적인 측면보다는 최대한 우선 쉽게 접근하는 걸 목표로 잡고 있기 때문에 이 점은 감안해서 봐주시면 감사하겠습니다. ^^ 이런 식으로 Docker를 Client에서도 다룰 수 있다는 것 정도로 보면 어떨까 싶습니다! ^^ 물론 이러한 API를 활용하여 Docker Host를 관리하도록 한다면 Docker의 명령을 직접 입력하지 않고 Application을 클릭하는 것만으로도 docker..

Docker : Part 6

Docker,Remote, API,client, library, python,host, 원격, 리모트, 도커, git : today Key Docker의 6번째 포스팅입니다. 이번 포스팅에서는 Docker를 Remote에서 제어할 수 있도록 제공되는 Remote API client libraries에 대해서 다뤄봅니다. 보안적인 측면보다는 최대한 우선 쉽게 접근하는 걸 목표로 잡고 있기 때문에 이 점은 감안해서 봐주시면 감사하겠습니다. ^^ 이런 식으로 Docker를 Client에서도 다룰 수 있다는 것 정도로 보면 어떨까 싶습니다! ^^ 물론 이러한 API를 활용하여 Docker Host를 관리하도록 한다면 Docker의 명령을 직접 입력하지 않고 Application을 클릭하는 것만으로도 docker..