Azure OpenAI Assistant - Part 3

Today Keys : azure, openai, assistant, service, function, calling, 함수, 호출, api 이번 포스팅에서는 Azure OpenAI Service의 Assistant 기능에 대한 사용법에 대해서 알아봅니다. 첫 번째와 두 번째 포스팅에서는 Azure Open AI Assistant의 Code Interpreter을 사용해 보는 것을 알아보았고, 이번 포스팅에서는 Azure Open AI Assistant의 또 다른 기능인, Function Calling 사용하는 예제를 살펴봅니다. Azure OpenAI를 사용하기 위한 서비스를 생성합니다. 먼저 각자의 Azure Open API Key와 Endpoint를 설정하고, API Version은 Azure Op..

Azure OpenAI Assistant - Part 3

Today Keys : azure, openai, assistant, service, function, calling, 함수, 호출, api 이번 포스팅에서는 Azure OpenAI Service의 Assistant 기능에 대한 사용법에 대해서 알아봅니다. 첫 번째와 두 번째 포스팅에서는 Azure Open AI Assistant의 Code Interpreter을 사용해 보는 것을 알아보았고, 이번 포스팅에서는 Azure Open AI Assistant의 또 다른 기능인, Function Calling 사용하는 예제를 살펴봅니다. Azure OpenAI를 사용하기 위한 서비스를 생성합니다. 먼저 각자의 Azure Open API Key와 Endpoint를 설정하고, API Version은 Azure Op..

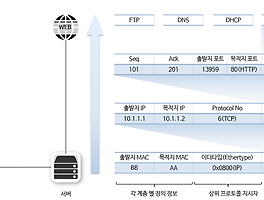

4계층 프로토콜(TCP, UDP)과 서비스 포트

Today Keys : protocol, 계층, service, port, 포트, 서비스, 헤더, 프로토콜, 지시자 본 포스팅은 'IT 엔지니어를 위한 네트워크 입문' [길벗] 서적에 포함된 '3. 네트워크 통신하기'의 내용 3.4.1장의 내용입니다. 4계층 프로토콜(TCP, UDP)과 서비스 포트 데이터를 보내고 받는 인캡슐레이션, 디캡슐레이션 과정에 각 계층에서 정의하는 헤더가 추가되고 여러 가지 정보가 들어갑니다. 다양한 정보 중 가장 중요한 두 가지 정보는 ● 각 계층에서 정의하는 정보 ● 상위 프로토콜 지시자 정보 입니다. 각 계층을 정의하는 정보는 수신 측의 동일 계층에서 사용하기 위한 정보입니다. 예를 들어 송신 측에서 추가한 2계층 헤더의 MAC 주소 정보는 수신 측의 2계층에서 확인하고 ..

4계층 프로토콜(TCP, UDP)과 서비스 포트

Today Keys : protocol, 계층, service, port, 포트, 서비스, 헤더, 프로토콜, 지시자 본 포스팅은 'IT 엔지니어를 위한 네트워크 입문' [길벗] 서적에 포함된 '3. 네트워크 통신하기'의 내용 3.4.1장의 내용입니다. 4계층 프로토콜(TCP, UDP)과 서비스 포트 데이터를 보내고 받는 인캡슐레이션, 디캡슐레이션 과정에 각 계층에서 정의하는 헤더가 추가되고 여러 가지 정보가 들어갑니다. 다양한 정보 중 가장 중요한 두 가지 정보는 ● 각 계층에서 정의하는 정보 ● 상위 프로토콜 지시자 정보 입니다. 각 계층을 정의하는 정보는 수신 측의 동일 계층에서 사용하기 위한 정보입니다. 예를 들어 송신 측에서 추가한 2계층 헤더의 MAC 주소 정보는 수신 측의 2계층에서 확인하고 ..

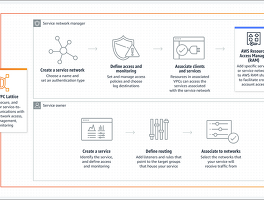

Amazon VPC Lattice - Part 8 : Control/Data Plane, Link-Local 등

Today Keys : aws,vpc, lattice, network, service, control, data, plane, api, link-local 이번 포스팅은 서로 다른 VPC 및 AWS 계정에 걸쳐 서비스 간의 네트워크 연결 및 애플리케이션 계층 라우팅을 자동으로 관리해주는 Amazon VPC Lattice에 대한 여덟 번째 포스팅입니다. 여덟 번째 포스팅에서는 VPC Lattice에 대한 기존 포스팅에서 다루지 않았던, VPC Lattice와 관련된 이런 저런 내용들을 짧게 짧게 다뤄 봅니다. 전반적으로 어떻게 VPC Lattice Service와 통신을 하게 되며, 네트워크 보안 정책이 어떻게 적용되는지에 대한 내용과 VPC Lattice Service에 접근하는 Client를 확인하는 ..

Amazon VPC Lattice - Part 8 : Control/Data Plane, Link-Local 등

Today Keys : aws,vpc, lattice, network, service, control, data, plane, api, link-local 이번 포스팅은 서로 다른 VPC 및 AWS 계정에 걸쳐 서비스 간의 네트워크 연결 및 애플리케이션 계층 라우팅을 자동으로 관리해주는 Amazon VPC Lattice에 대한 여덟 번째 포스팅입니다. 여덟 번째 포스팅에서는 VPC Lattice에 대한 기존 포스팅에서 다루지 않았던, VPC Lattice와 관련된 이런 저런 내용들을 짧게 짧게 다뤄 봅니다. 전반적으로 어떻게 VPC Lattice Service와 통신을 하게 되며, 네트워크 보안 정책이 어떻게 적용되는지에 대한 내용과 VPC Lattice Service에 접근하는 Client를 확인하는 ..

Amazon VPC Lattice - Part 7 : 소개, 주요 개념

Today Keys : aws,vpc, lattice, network, service, amazon, 개념, auth, policy, directory 이번 포스팅은 서로 다른 VPC 및 AWS 계정에 걸쳐 서비스 간의 네트워크 연결 및 애플리케이션 계층 라우팅을 자동으로 관리해주는 Amazon VPC Lattice에 대한 일곱 번째 포스팅입니다. 일곱 번째 포스팅에서는 VPC Lattice에 대한 서비스 소개와 간단한 개념에 대해서 다룹니다. 원래 개념을 다루면서 VPC Lattice에 대한 포스팅을 마무리 하려고 했는 데, 기존에 정리하지 않은 내용과 함께 이번 장을 정리하면서 추가로 정리하고 싶은 내용들이 조금 더 생기면서 다음 포스팅이 VPC Lattice에 대한 마지막(당분간) 포스팅이 될 것 ..

Amazon VPC Lattice - Part 7 : 소개, 주요 개념

Today Keys : aws,vpc, lattice, network, service, amazon, 개념, auth, policy, directory 이번 포스팅은 서로 다른 VPC 및 AWS 계정에 걸쳐 서비스 간의 네트워크 연결 및 애플리케이션 계층 라우팅을 자동으로 관리해주는 Amazon VPC Lattice에 대한 일곱 번째 포스팅입니다. 일곱 번째 포스팅에서는 VPC Lattice에 대한 서비스 소개와 간단한 개념에 대해서 다룹니다. 원래 개념을 다루면서 VPC Lattice에 대한 포스팅을 마무리 하려고 했는 데, 기존에 정리하지 않은 내용과 함께 이번 장을 정리하면서 추가로 정리하고 싶은 내용들이 조금 더 생기면서 다음 포스팅이 VPC Lattice에 대한 마지막(당분간) 포스팅이 될 것 ..