NordVPN - Register/Install/Usage

Today Keys : NordVPN, VPN, install, setup, register,usage,how to use,china, cloud, test,cdn In this post, we will learn how to install and use Nord VPN. If you use a VPN program, you can access the site you want by using a domestic or overseas VPN server as a detour. In other words, by using a VPN, you can make it as if you are connecting from any country other than Korea, such as the US or Euro..

NordVPN - Register/Install/Usage

Today Keys : NordVPN, VPN, install, setup, register,usage,how to use,china, cloud, test,cdn In this post, we will learn how to install and use Nord VPN. If you use a VPN program, you can access the site you want by using a domestic or overseas VPN server as a detour. In other words, by using a VPN, you can make it as if you are connecting from any country other than Korea, such as the US or Euro..

NordVPN(노드VPN) - 가입/설치/사용법 예제

Today Keys : NordVPN, 노드, Nord VPN, install, setup, 설치, 사용, 방법, 우회, 중국, 넷플릭스, 디즈니 이번 포스팅에서는 노드 VPN(Nord VPN)의 설치 및 사용법에 대해서 알아 봅니다. VPN 프로그램을 이용하면, 국내 혹은 해외의 VPN 서버를 우회 경로로 사용하여 원하는 사이트에 접속할 수 있습니다. 즉, VPN을 사용하면 한국이 아닌 미국이나, 유럽같은 원하는 국가에서 접속하는 것처럼 할 수 있습니다. 따라서, 특정 국가에서만 제공되는 컨텐츠를 한국에서도 동일하게 볼 수 있습니다. >> 노드 VPN(Nord VPN) 사이트 [바로가기] The best VPN service for protecting your sensitive data | NordVP..

NordVPN(노드VPN) - 가입/설치/사용법 예제

Today Keys : NordVPN, 노드, Nord VPN, install, setup, 설치, 사용, 방법, 우회, 중국, 넷플릭스, 디즈니 이번 포스팅에서는 노드 VPN(Nord VPN)의 설치 및 사용법에 대해서 알아 봅니다. VPN 프로그램을 이용하면, 국내 혹은 해외의 VPN 서버를 우회 경로로 사용하여 원하는 사이트에 접속할 수 있습니다. 즉, VPN을 사용하면 한국이 아닌 미국이나, 유럽같은 원하는 국가에서 접속하는 것처럼 할 수 있습니다. 따라서, 특정 국가에서만 제공되는 컨텐츠를 한국에서도 동일하게 볼 수 있습니다. >> 노드 VPN(Nord VPN) 사이트 [바로가기] The best VPN service for protecting your sensitive data | NordVP..

Puppet Part2

Today key : Puppet, 퍼펫, manifest, autumation, 자동화, ruby, resource, title, attribute, value, 명세서 지난 번에 이은, Puppet의 2번째 포스팅입니다. 사실 이번 포스팅은 예전에 정리했던 Automation for Networker 주제의 포스팅을 다시 재가공하였습니다. 기존에 포스팅한 것보다는 조금 내용이 변경 혹은 추가 되었습니다. 앞으로 몇 번에 걸쳐서 추가 포스팅이 되지 않을까? 싶습니다. 단지, 포스팅 전에 테스트와 무작정 정리한 걸 다시 포스팅 용으로 작성 하는 데 시간이 걸려서. 언제 올라올지는 모르겠지만.. 멀지 않은 시일 내에 또 올리도록 하겠습니다. 그리고 혹시 잘못되거나 수정해야 할 부분이 있으면 덧글 부탁드립니..

Puppet Part2

Today key : Puppet, 퍼펫, manifest, autumation, 자동화, ruby, resource, title, attribute, value, 명세서 지난 번에 이은, Puppet의 2번째 포스팅입니다. 사실 이번 포스팅은 예전에 정리했던 Automation for Networker 주제의 포스팅을 다시 재가공하였습니다. 기존에 포스팅한 것보다는 조금 내용이 변경 혹은 추가 되었습니다. 앞으로 몇 번에 걸쳐서 추가 포스팅이 되지 않을까? 싶습니다. 단지, 포스팅 전에 테스트와 무작정 정리한 걸 다시 포스팅 용으로 작성 하는 데 시간이 걸려서. 언제 올라올지는 모르겠지만.. 멀지 않은 시일 내에 또 올리도록 하겠습니다. 그리고 혹시 잘못되거나 수정해야 할 부분이 있으면 덧글 부탁드립니..

Puppet Part 1

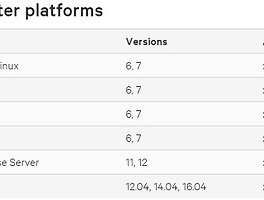

Today key : Puppet, 퍼펫, manifest, autumation, 자동화, 설치, install, master, agent 이번 포스팅은 Puppet에 대한 포스팅입니다. 약 2년여전에 관련 Automation for Networker라는 주제로 포스팅을 할 때 ansible과 함께 잠깐 정리했던 내용을 다시 정리해보려고 합니다. 아무래도 제 포스팅이 대체로 제가 다시 보기 위해서 정리하면서 공유하는 게 목적이오니~ 보시는 분들은 참고하시면 되겠습니다 ^^ 그리고 혹시 잘못되거나 수정해야 할 부분이 있으면 덧글 부탁드립니다! ^^ Puppet를 사용하기 위한 요구사항 ◇ 하드웨어 · 최소 Puppet master server : 2CPU Core, 1GB RAM · 약 1,000 node..

Puppet Part 1

Today key : Puppet, 퍼펫, manifest, autumation, 자동화, 설치, install, master, agent 이번 포스팅은 Puppet에 대한 포스팅입니다. 약 2년여전에 관련 Automation for Networker라는 주제로 포스팅을 할 때 ansible과 함께 잠깐 정리했던 내용을 다시 정리해보려고 합니다. 아무래도 제 포스팅이 대체로 제가 다시 보기 위해서 정리하면서 공유하는 게 목적이오니~ 보시는 분들은 참고하시면 되겠습니다 ^^ 그리고 혹시 잘못되거나 수정해야 할 부분이 있으면 덧글 부탁드립니다! ^^ Puppet를 사용하기 위한 요구사항 ◇ 하드웨어 · 최소 Puppet master server : 2CPU Core, 1GB RAM · 약 1,000 node..

VMware Photon -Part 2 [VIC & Photon Platform 소개]

Photon, VMware, Integrated, Container, install, git, iso, platform, os, 컨테이너, 포톤, vm웨어, Docker, rkt : Today Key VMware의 Container 전략(?), 지원 방향(?)인 Photon에 대한 2번째 포스팅입니다. 지난 번에 설치해 본 Photon OS에 대해서 간략히 알아보고, 실제 Container 지원에 대한 내용인 vSphere Integrated Containers & Vmware Phton Platform에 대해서 각각 알아봅니다. Photon OS에 대해서만 현재 TPv2로 나오고, 그 이외는 아직 출시가 되지 않았기 때문에 정리된 내용이 일부 실제 내용과 다를 수도 있지 않을까? 싶습니다. 혹시 수정해..

VMware Photon -Part 2 [VIC & Photon Platform 소개]

Photon, VMware, Integrated, Container, install, git, iso, platform, os, 컨테이너, 포톤, vm웨어, Docker, rkt : Today Key VMware의 Container 전략(?), 지원 방향(?)인 Photon에 대한 2번째 포스팅입니다. 지난 번에 설치해 본 Photon OS에 대해서 간략히 알아보고, 실제 Container 지원에 대한 내용인 vSphere Integrated Containers & Vmware Phton Platform에 대해서 각각 알아봅니다. Photon OS에 대해서만 현재 TPv2로 나오고, 그 이외는 아직 출시가 되지 않았기 때문에 정리된 내용이 일부 실제 내용과 다를 수도 있지 않을까? 싶습니다. 혹시 수정해..

VMware Photon -Part 1 [Install]

Photon, VMware, Container, install, git, iso, platform, os, 컨테이너, 포톤, vm웨어, Docker, rkt : Today Key VMWare에서 Container를 위한 Container 전용 OS인 Photon을 VMWorld 2015에서 발표하였습니다. Photon과 관련한 2가지 방향인 VIC와 Photon Platform은 곧 다음 포스팅에서(빠르면 이번 주내?) 다뤄질 예정이며.. 우선 무작정 누구나 따라하기 쉬운 Photon OS 설치를 이번 포스팅에서 다뤄봅니다. VMWare Photon OS 설치하기 Photon OS • VMWare에서 Container를 위한 내놓은 Container OS • ISO(Full, Minimal), OVA로 ..

VMware Photon -Part 1 [Install]

Photon, VMware, Container, install, git, iso, platform, os, 컨테이너, 포톤, vm웨어, Docker, rkt : Today Key VMWare에서 Container를 위한 Container 전용 OS인 Photon을 VMWorld 2015에서 발표하였습니다. Photon과 관련한 2가지 방향인 VIC와 Photon Platform은 곧 다음 포스팅에서(빠르면 이번 주내?) 다뤄질 예정이며.. 우선 무작정 누구나 따라하기 쉬운 Photon OS 설치를 이번 포스팅에서 다뤄봅니다. VMWare Photon OS 설치하기 Photon OS • VMWare에서 Container를 위한 내놓은 Container OS • ISO(Full, Minimal), OVA로 ..